スクウェア・エニックス オープンカンファレンスレポート(前編)

スクウェア・エニックスの次世代ゲームエンジンのグラフィックスの全て

スクエニ流“実写クオリティ”のゲームグラフィックスの作り方

株式会社スクウェア・エニックスは10月8日、同社のテクノロジー推進部が研究開発中の技術や、現在同部で研究開発中の「Luminous Studio」に実装されつつある技術を報告するカンファレンス「スクウェア・エニックス・オープンカンファレンス」を開催した。弊誌ではカンファレンスの模様を前後編に分けてお届けしたい。

なお、本文中、「Luminous Studio」に関して記述している箇所の中に、厳密には、現在、開発中のLuminous Studio上で動作するテクノロジーデモ「Philosophy」について言及している箇所もある。概念的にはPhilosophyは、Luminous Studio上に実装された(あるいは実現しうる)多様な機能のうちの、一部を選択して開発が進められているものだ。本文では、このニュアンスを残して説明することが難しかったため、解説の都合上、「Luminous Studio」という表記に統一しているのでご了承いただきたい。

■ スクウェア・エニックスがゲーム開発者を対象とした無料の技術カンファレンスを開催

|

| 開幕の挨拶を行なう和田洋一氏(スクウェア・エニックス代表取締役社長) |

「スクウェア・エニックス・オープンカンファレンス」は、「トップゲームスタジオが開催する完全無料の技術カンファレンス」という触れ込みで募集が行なわれたため、告知後、申し込みが殺到し、瞬く間に定員オーバーに達して参加募集が打ち切られるという人気ぶりを見せた。募集打ち切り後も参加希望者の問い合わせが後を絶たず、元々は開催場所はスクウェア・エニックス社内で執り行なう予定だったものが、より大きな新宿エルタワービルのカンファレンスルーム会場での開催に切り替えて、再募集を行なったほどだった。

こうした無料カンファレンスの開催は、ソフトウェアエコシステムを育成する意味合いから、インテルやNVIDIAなどのハードウェアメーカー、あるいはマイクロソフトのようなOSメーカーが開催することはしばしばあるが、ゲームスタジオが、しかも日本のゲームスタジオが開催することは非常に珍しい。

これについて、冒頭で開催の挨拶を行なったスクウェア・エニックス代表取締役社長・和田洋一氏は今回の件について以下のように説明した。

欧米では、開発者同士の技術交流が盛んで、技術交流カンファレンスの開催自体が珍しくない。そしてゲームエンジンの概念が早くから浸透している欧米では、ゲームエンジンのフォーラム・コミュニティも活発だ。一方、日本のゲーム業界は、技術を囲い込む方向の文化が強く根付いてしまった。CEDECのようなゲーム開発者向けのカンファレンスの年次開催で、そうした「囲い込み文化」が和らぎつつはあるが、ゲームスタジオ間の壁を越えての「距離感の近い交流」の機会はまだまだ少ない。閉塞感漂う日本のゲーム業界を盛り上げていくためには、いわば「チームジャパン」としてゲームスタジオ同士が手を取り合ってゲーム開発シーン全体を盛り上げて行く必要がある。それには、オープンコミュニティの文化が日本のゲーム開発シーンにも必要なのではないか……。

「日本のゲーム開発シーン」を「業界のみんなで発展させていこう」という意図から、今回の開催になったというのだ。大変、志の高い試みである。ぜひとも、1回で終わらず、幾度となく開催を期待したいものだ。

さて、本カンファレンスは「グラフィックス編」、「AI&アニメーション編」、「ゲームエンジン&マネジメント編」の3部構成で行なわれ、各部では2セッションずつ、合計6セッションが執り行われた。

本稿ではそのうち、「グラフィックス編」の2セッション、「AI&アニメーション編」の1セッションをレポートする。本稿でカバーしていない残り3セッションは、後編を参照して頂きたい。

■ グラフィックス編(1)~「DirectX 11最新リアルタイム映像事例集」

|

| テッセレーション技術関連について講演したRemi Driancourt氏(シニア R&D エンジニア) |

|

| ComputeShader技術関連について講演したGavrenkov Ivan氏(グラフィックスプログラマー) |

「Luminous Studio」については、既に筆者の連載「3Dゲームファンのためのグラフィックス講座」の「Luminous Studio」講座でも取り上げているので未読の方はぜひご一読いただきたい。連載でも触れたようにスクウェア・エニックスの新世代ゲームエンジン「Luminous Studio」は、そのグラフィックスエンジン部分はネイティブDirectX 11で設計されている。

第一セッションは、「Luminous Studio」のグラフィックスエンジンにDirectX 11ベースのグラフィックス技術を実装するにあたって、実際に検証した技術の数々が紹介された。DirectX 11におけるグラフィックスフィーチャーの花形と言えば「テッセレーションステージ」と「Compute Shader」(Direct Compute)ということになるが、セッションもその2テーマに絞った内容となっていた。

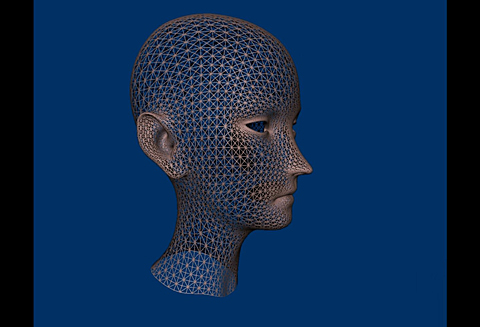

テッセレーションステージは、筆者の連載でも幾度となく触れてきているので詳細は省略するが、簡単に言えば、3Dモデルを構成するポリゴンを分割して、それに対して「盛ったり削ったり」といった変位を与えることができる機能になる。

「Luminous Studio」では、様々なテッセレーションメソッドについて検討した結果、既に使用しているDCCツールが広く採用しているCatmull Clark法の近似版である「Approximating Catmull Clark」(ACC)法を選択したという。ACC法はCharles Loop氏(マイクロソフトリサーチ)、Scott Schaefer氏(テキサスA&M大学)らが考案したもので、詳細の論文はこちら(http://research.microsoft.com/en-us/um/people/cloop/accTOG.pdf)で公開されている。

| 【テッセレーションステージ】 | |

|---|---|

|  |

| テッセレーションステージの概念図(左)。「Luminous Studio」では「Approximating Catmull Clark」(ACC)法を選択(右) | |

| 【ACC法のアルゴリズム基本概念】 | |

|---|---|

|  |

| 【ACC法によるテッセレーション】 |

|---|

|

| ルミナススタジオ開発チームが実装したACC法によるテッセレーションのデモ映像 |

|

| ディスプレースメントマッピングとは3Dモデルに対して盛ったり削ったりを行なうテクニック。ジオメトリレベルでのディテールの付加やモーフィング表現などに適しているとされる |

基本概念としては、ベースとする分割対象単位をクワッド(四角形)とし、8個のエッジ(輪郭)点、4個のコーナー(隅)点、4個のインテリア(内)点、総計16個の制御点でベジェパッチを生成する。ベジェパッチとは高次曲線のベジェ曲線に従って曲面を表現するものだ。

テッセレーションステージの醍醐味は、ジオメトリレベルの凹凸を適用するフィーチャー「ディスプレースメントマッピング」にもある。「Luminous Studio」では、凹凸量を記載したテクスチャ「ハイトマップ」から変位量を読み出して、適用先ポリゴンの法線方向にバイアスする形で適用する最も基本的なディスプレースメントマッピングの手法はもちろんのこと、やや高度なディスプレースメントマッピング手法にも対応する。

それは「ベクトル・ディスプレースメントマッピング」だ。テクスチャには変位量だけでなく、その変位方向までを記載した、いわば「ベクトルマップ」を読み出して適用先ポリゴンを変位させる。元のポリゴンが持つ法線ベクトルと合成するのか平均を取るのか、はたまた無視をするのかは語られなかったが、いずれにせよ、突起するだけでなく、広がって張り出すような凹凸を作り出すことができるのが、このテクニックのウリになる。

| 【ディスプレースメントマッピング】 | |

|---|---|

|  |

| 「Luminous Studio」では法線方向に凹凸を付加する基本的なディスプレースメントマッピングには当然対応している | |

| 【ベクトルディスプレースメントマッピング】 | |

|---|---|

|  |

| 「Luminous Studio」では、広がって張り出すような凹凸を作り出せる「ベクトルディスプレースメントマッピング」にも対応する | |

|

| 静的なオブジェクトへのディテール付加にはテッセレーションを活用すべきではない |

|

| テッセレーションを使うべきなのは動的なキャラクタに対して。GPUにハードウェアLODを任せられるというメリットもある |

こうしたテッセレーションにまつわる様々な実験をする中で、開発チームは、「GPUベースのテッセレーションをどう使うべきか」という傾向と対策を見出すことに至った。

いきなり語られたのは「テッセレーションステージを使うべきでない」という「後ろ向き」な経験則についてだ。まず、背景などの動かない静的なオブジェクトに対するディテール付加目的には使用すべきではない、と説明された。

例えば、彫刻のような複雑なモデルをDCCツール上でデザインして、これを低ポリゴンのモデルに変換し、ディテール部分をディスプレースメントマッピングで再現しようとしてもほとんどうまくいかない。費用対効果の面でも美味しくないというのだ。

逆に「テッセレーションステージを活用すべき」という局面も紹介された。それはLevel of Detail(LOD)の処理系をテッセレーション側に任せようとする場合だ。裏を返せば、動的に動くようなキャラクタモデルに用いるのが望ましいということだ。

その裏付け的データとして示されたのは、10MB分のジオメトリデータからなる4万ポリゴンの多ポリゴンモデルをアニメーション付きで動かしたときのフレームレートと、628KBのジオメトリデータからなる2,500クワッド(約5,000ポリゴン)の低ポリゴンモデルにACC法のテッセレーションを掛けて、さらに223KBのディスプレースメントマッピングを適用して、前出の4万ポリゴンの3Dモデルとほぼ同一品質にしてアニメーション付きで動かしたときのパフォーマンス比較データだ。

結果は、未最適化状態でありながら、後者の方が10%近くパフォーマンスが良い。最適化すればパフォーマンスはさらに向上するだろうし、なによりメモリ占有率がテッセレーションステージ活用事例の方が1/10というのが、費用対効果として大きい。

ただ、テッセレーションステージにはやや扱いにくい“じゃじゃ馬”的な側面もある。1つは、曲面パッチベースのテッセレーションを行なう事で、鋭い突起や、シャープな切れ目、折り返し(CREASE)が、失われてしまうという問題だ。この問題はACC法に限らず、別の手法のテッセレーション技法でもよく浮上する課題だ。

よく用いられるのは頂点単位にテッセレーションさせないフラグに相当するマスク情報を持たせる方法だが、「Luminous Studio」では、この問題に対し、折り返し(CREASE)の重み情報を持たせる方策で対処している。

具体的には、各クワッドの各辺(エッジ制御点)に「どのくらいシャープか」の重み情報を持たせておき、ハルシェーダでベジェ曲面状に変位させる段階で、トップ3の重み情報を読み出し、その組み合わせで変位量を決定するアルゴリズムを実装している。イメージ的には、重み情報の大きいエッジ制御点が多ければ多い箇所ほど、ベジェ曲面によるカーブ生成がキャンセルされてシャープなエッジが残るといった感じだ。

| 【折り返し重み情報】 | |

|---|---|

|  |

| 「シャープな表現もみんな丸くなってしまう」というテッセレーション活用の際によく挙がる課題(左)。これに対して「Luminous Studio」開発チームは「折り返し重み情報」を導入することで対処した(右) | |

2つ目はクラック(ひび割れ)の問題。テッセレーションを行なったり、ディスプレースメントマッピングを行なったりすると、3Dモデルの表皮状にひび割れが出てしまうことがある。

これらの原因としては「接平面の不連続性」、「ディスプレースメントマッピングの際の変位テクスチャのサンプリングエラー」などが考えられるわけだが、前者についてはエンジン側のプリプロセスツールで不連続性を解消させたり、特異点箇所を監視して、そこにはディスプレースメントマッピングを行なわない仕組みを盛り込んだとのことだ。ディスプレースメントマッピングの際の変位テクスチャ読み出しエラーはジオメトリ解像度と変位テクスチャ解像度のズレが大きい時に発生しやすいので、これにはMIP-MAPの概念を持ち込んで対処する。

|  |  |

| クラックの問題(左)は、事前処理でこれに対処(中)。ディスプレースメントマッピングの際に使用する変位テクスチャに関しては必要に応じてMIP-MAPの概念を導入(右) | ||

グラフィックス関連セッションの後半は、ComputeShaderにまつわる話題が語られた。 「Luminous Studio」開発チームとしては、次世代機ではGPGPU技術の活用が必須となると考えており、この分野にも力を入れて取り組んでいる。

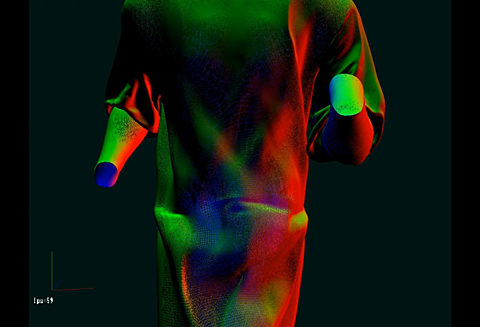

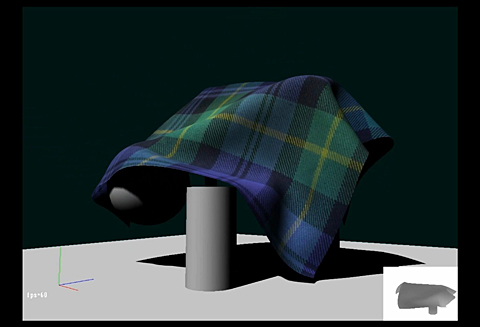

幾つかの実験を経て、「Luminous Studio」に採用したGPGPUベースの実装フィーチャーとしては「布のシミュレーション」、「パーティクルシステム」が挙げられた。前者は、「ベルレ積分」を活用した位置ベースの物理シミュレーションでの実装となっていた。ベルレ積分ベースの物理シミュレーションといえば、カプコンの「ドラゴンズドグマ」でも実装されていたアプローチだ。

|  |  |

| ベルレ積分を用いた位置ベースの物理シミュレーションで実装される布シミュレーション | ||

| 【布シミュレーション】 |

|---|

|

|

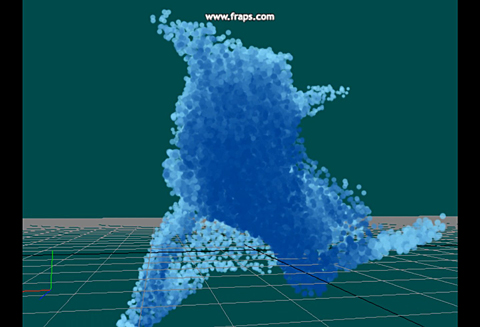

パーティクルシステムに関しては、10万個以上のパーティクルを出現させることを次世代表現の目標としていることから、テクノロジー推進部としては「GPU内部で帰結できるパーティクルシステム」の設計に取り組んでいる。その設計の実現にComputeShaderベースのGPGPU的アプローチは最有力手段ということのようだ。

現在でも、パーティクルに対して厚み情報等を付加し、疑似ライティングの仕組みを導入してボリュメトリックな表現を実現しているゲームタイトルは存在するが、テクノロジー推進部ではそこから一歩踏み込んで、セルフシャドウ付きのパーティクル描画システムを実装している。これは既にCRYTEKや「3DMARK11」のFUTUREMARKが実践している方法とよく似たもので、光源方向から適当な数で分割した空間に対してシャドウマップを生成する方式のメソッドだ。

面白かったのは、このパーティクルシステムでは、パーティクルの挙動制御に疑似流体物理シミュレーションが適用できる仕組みだ。この疑似流体物理シミュレーションは、ブリティッシュ・コロンビア大学の研究グループが発表した「Curl-Noise for Procedural Fluid Flow」と呼ばれる手法がベースとなっている。これはパーリンノイズをベースとした2次元ノイズ関数を用いて、巻き込むような力場を得るプロシージャル的手法だ。

| 【パーティクル】 | ||

|---|---|---|

|  |  |

| 「Luminous Studio」の次世代パーティクルシステム | ||

| 【パーティクルシステムのデモ】 |

|---|

|

| 前半はセルフシャドウ付きGPGPUベースパーティクルシステムのデモ。後半は疑似流体物理シミュレーションによって動いているパーティクルのデモだ |

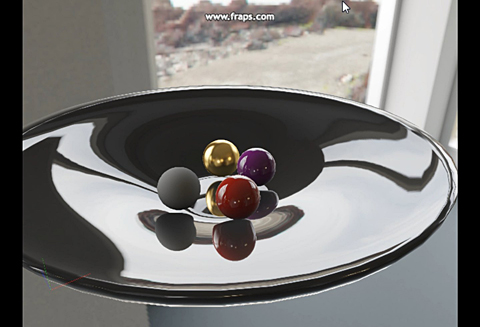

この他、セッション内では、DirectX 11フィーチャーではないが、レンダリング結果に対し、画面座標系で局所的なレイトレーシング的なテクニックを応用して実践する「リアルタイム・ローカル・リフレクション」(RLR)などのテクニック等を実装したことも報告された。これは、CRYTEKの実装と同アプローチの手法だという。

RLRについては、筆者の連載「西川善司の3Dゲームファンのための『E3 2011』グラフィックス講座」にて解説しているのでそちらをご覧頂きたい。

| 【リアルタイム・ローカル・リフレクション】 |

|---|

|

| 球体への映り込みは環境マップ。テーブルへの球体の映り込みがRLRによるものだ |

■ グラフィックス編(2)~「リアルタイム用フォトリアル背景モデル作成講座」

|

| 岩田 亮氏(リードアーティスト) |

現在、スクウェア・エニックスのテクノロジー推進部では「Luminous Studio」の研究開発に取り組んでいるが、そのエンジンの水準を高める目的でテクノロジーデモの製作も並行して行われている。そのテクノロジーデモ「Philosophy」の開発の中心的な人物がリードアーティストの岩田亮氏だ。

グラフィックス関連セッションの後編では、この岩田氏が、フォトリアルなグラフィックスを製作するための基礎テクニックについて「リアルタイム用フォトリアル背景モデル作成講座」と題した講演を行なった。

フォトリアル、すなわち写実的なグラフィックスを製作するためには、現実世界情景のベンチマークがあったほうがよい。ただし、製作を複数の開発メンバーで行なうためには、具体的な共通ゴールが必要になる。岩田氏は、これについて最も基本的かつ手軽なものとして「デジタル写真」を挙げた。

| 【デジタル写真】 | |

|---|---|

|  |

| お手本の写真を撮る(左)。これを基準とし、ゴールとする。次にプリレンダーCGを作成し(右)、それをさらにリアルタイムに落とし込む。「Luminous Studio」開発チームはこうした基礎実験を行なった | |

再現したいシーンや、それに近いシーンを、デジカメで写真撮影を行ない、それをゴールとしてCGでの再現を目指すわけだ。岩田氏のセッションでは、そうしたデジカメで撮影した写真から素材の反射率を求めるテクニックが話された。

得られる反射率は、基本的には拡散反射の反射率になる。もちろん、異方性の反射特性がある素材や、鏡面反射特性がある材質などは、このパラメータだけでは一筋縄には行かないが、得られた反射率は素材表現において有益な情報になる。この反射率の取得には市販されている「銀一シルクグレーカード」を利用する。

この銀一シルクグレーカードは、入射した光を18%だけ拡散反射する特性があるシートで、反射率を測定したい対象物と共に、適当な大きさに切ったこのカードを添えてデジカメで写真を撮影する。

| 【銀一シルクグレーカード】 | ||

|---|---|---|

|  |  |

| お手本写真を銀一シルクグレーカードと共に撮影する。カットする際、一辺の大きさを何cmと決めておくと、後で対象物のサイズの割り出しにも役立つというTIPSも。その撮影結果をレタッチして銀一シルクグレーカードをキーにして写真の照明条件を正規化して、写真内の素材の反射率を取得していく | ||

その写真を、フォトレタッチソフトなどで読み込み、まずは写真中の銀一シルクグレーカードを基準にホワイトバランスを整える。この状態から露光量(輝度バランス)の調整を行なって、写真中の銀一シルクグレーカードの灰色の箇所のRGBの各要素が18%の値に揃うように調整する。この調整を行なう事で、写真に映っているもの達が全て、正規化された白色光(たとえばR=G=B=255)の下で照らされた時の反射状態にできる。すなわち、この時の写真中の各素材の色は、最大輝度の完全な白色光が当たったときの反射色(RGBの反射率)ということになる。

ただ、デジカメの写真は、デジカメ側の画像処理エンジンが記憶色再現処理を行なってしまう場合があるため、撮影はできるだけ光の物理量を正確に記録できる画調モードを選択した方がいい、というアドバイスもあった。また、フォトレタッチソフトで調整を行なう際、不当な丸め誤差を避ける意味合いからも、取り扱う写真はHDR(ハイダイナミックレンジ)であることも求められる。

セッションでは、実在のフォトレタッチソフトを使用して、具体的な作業工程なども示されたが、そうした内容についてはカンファレンス当日だけの限定情報ということなので本稿ではザックリとした概念理論の紹介に留めている点をご理解いただきたい。

こうして得た反射率を元に素材表現を行なってグラフィックスを作成すると、光の条件が異なった場合にも、現実世界に近い結果が得られる。写真でお手本としたシーンを再現できるだけでなく、照明条件やシーンを変えても写真的なリアルな映像が構築できるようになるということだ。これは物理ベースレンダリングの堅牢な特長の1つでもある。

| 【フォトリアルな結果】 | ||

|---|---|---|

|  |  |

| このアプローチで求めた素材を用いてシーンをレンダリングすると、お手本としたシーン以外でレンダリングしても説得力のあるフォトリアルな結果が得られる | ||

そして、こうして求めた表現したい素材の反射率のストックを充実化させることで、写真撮影ができない素材に対しても、相対的に「この辺りの反射率となるはず」というような推測もできる、と岩田氏は述べていた。既にその反射率が正しいことがわかっている素材を並べてレンダリングし、そこに新たに表現したいモデルも同時にレンダリングし、照明条件を色々と変えて、その表現したいモデルの素材のパラメータを、イメージが近くなるように調整を追い込んでいくのだ。

なお、筆者の連載の「Luminous Studio」講座の最後に掲載した駐車場のシーンの各素材も、今回紹介されたテクニックで集められたパラメータが用いられている。

| 【デジタル写真】 | |

|---|---|

|  |

| 実写(左)とリアルタイムレンダリング(右) | |

| 【地下駐車場再現シーン】 |

|---|

|

|

|

|

| 実は、先行公開された「地下駐車場再現シーン」はその奥もちゃんと作り込まれていた! |

| 【地下駐車場動画】 |

|---|

|

■ アニメーション編~「歩行制御プロシージャルアニメーション他最新アニメーション技術紹介」

|

| 向井智彦氏(アニメーション担当リードリサーチャー) |

|

| 「優先順位付きフルボディIK」 |

「Luminous Studio」で重視している要素としてアニメーションがある。モーションキャプチャによって取得したモーションデータベースのアニメーションは、ゲームグラフィックスの表現手段が3Dグラフィックスに移行してからは当たり前の技術となったが、動的に変化するゲームシーンに対して、つじつまの合う形でアニメーションを適合させる手段や、あるいは複数のモーションデータを組み合わせて新しいモーションを生成するような手段は、未だ各所で研究が進行中という段階だ。

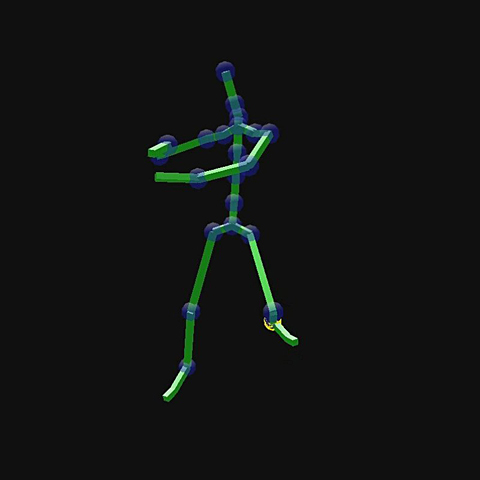

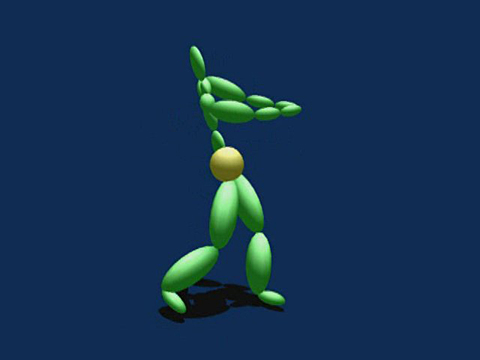

アニメーション担当リードリサーチャー向井智彦氏は、まさに、この分野の専門家だ。向井氏のセッションでは、「Luminous Studio」に実装される予定のアニメーション関連の研究成果について語られた。1つ目は、最近流行のフルボディIKの話題だ。

IKとは、逆(方向)運動学(Inverse Kinematics)と言われるもので、例えばある目的の場所に手先や足先を移動させた場合に、各関節をどう回転させたり、曲げたりすればいいかを求めるものだ。一方、順(方向)運動学(Forward Kinematics)は、各関節を回転させたり曲げたりすると手先や足先はどこに行くかを求めるものになる。そして、フルボディIKとは、手先を動かしたり足先を動かしたりしたときに、手や足の関節だけでなく身体全体の姿勢までを制御するものになる。

向井氏が最初に紹介したのは、「優先順位付きフルボディIK」と呼ばれるもの。これは読んで字の如く、優先順位条件を与えてIKを計算するものになる。例えば、足の接地が優先されるときは、地面から足をなるべく離さずに手を動かす……といったIK制御になる。

| 【優先順位付きフルボディIK】 |

|---|

|

|

2つ目は「力学的リターゲティング」と呼ばれるプロシージャル的モーションアレンジ技術だ。これは、「剣を振る」といったような、何かの重量物を操作したモーションデータがあったとして、その重量物の重さが変化したときのアニメーションを既存のモーションデータからプロシージャルにアレンジ生成するものになる。「力学的リターゲティング」では、操作対象物の重量が変わっても、元々のモーションの重心位置をなるべく維持するような制御を加えることで実現する。

| 【オリジナルモーションと操作対象物の重量を増加させて生成したプロシージャルモーションの比較( ゴルフ編)】 |

|---|

|

|

| 【オリジナルモーションと操作対象物の重量を増加させて生成したプロシージャルモーションの比較(野球編)】 |

|---|

|

|

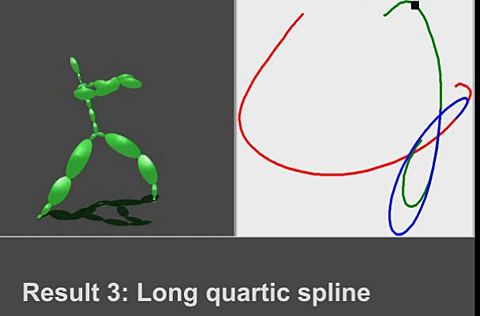

3つ目は、異なる2つのモーションを自然に繋ぐ手段についての技術だ。一般には、繋げる2つのモーションをオーバーラップさせ、それをブレンドするモーションブレンドの手法がよく用いられるが、向井氏の研究では、ブレンドする2つのモーションの間にプロシージャル生成したモーションを挟んで繋ごうというアプローチになる。

その補間モーションの生成にはスプライン補間のアルゴリズムを利用する。ただ、モーションデータとは、各ボーンの時間方向の変位量であり、時間方向の多次元情報になるため、一意的なスプライン補間が難しい。そこで、向井氏の手法では、マーケティングリサーチなどでも用いられるような多次元尺度構成法で低次元に写像し、これに対してスプライン補間をして、その結果を再び多次元のモーションデータに復元するアプローチを取る。

| 【モーションを繋ぐ】 | |

|---|---|

|  |

| プロシージャル生成したモーションを間に補間してモーションを繋ぐという発想 | |

| 【SIGGRAPH ASIA 2011】 |

|---|

|

| この内容はSIGGRAPH ASIA 2011にて発表される予定 |

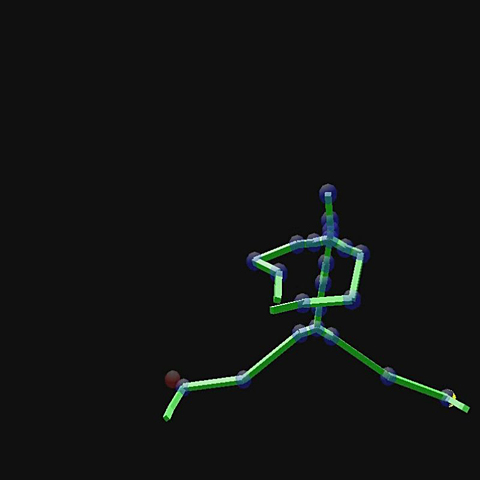

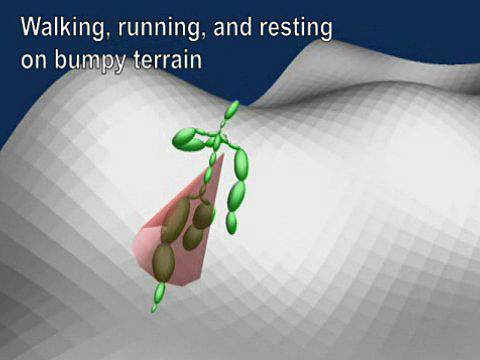

続いて、現在も開発中の歩行動作生成アルゴリズムについての話題が取り扱われた。 最初に紹介されたのは、あらゆる地面の高低差に対応でき、しかも現実的にりあうるあらゆる方向とあらゆる歩幅で自然に歩行する「データ駆動型アプローチの歩行モーション生成技術」だ。

具体的には、約40個程度の歩行モーションおよび走行モーションのモーションキャプチャを事前に行なって、このモーションデータ群をベースにして新しいモーションを生成するという方向性になる。

| 【歩行モーション生成】 | |

|---|---|

|  |

|  |

| データ駆動型アプローチの歩行モーション生成(左上)、基本ループ(右上)、要素技術(左下)、最低限のモーションデータはモーションキャプチャにて取得。データの正規化や解析は事前計算で行なう(右下) | |

| 【データ駆動型アプローチの歩行モーション生成】 |

|---|

|

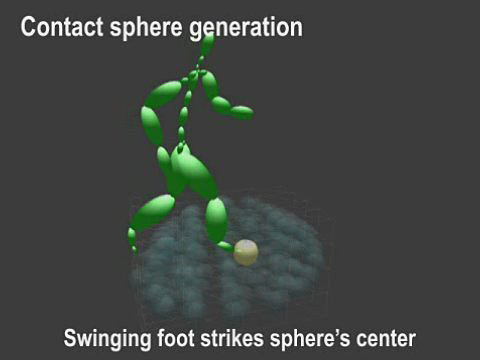

実際のランタイムにおける歩行モーション生成では、まず次に踏み出す足の位置を移動方向や地形に配慮して決定し、その足の位置に至る歩行モーションを合成することになるのだが、面倒そうなのは足と地面の衝突位置決定だ。

これについては、事前計算で対処する。具体的には、足を踏み出した際に着地しうる足の位置をたくさん事前に求めておき、各位置に衝突判定用の仮想球を生成しておく。ランタイムでは、踏み出し先の足位置がどの仮想球になるのか…を決定する「仮想球と地面との衝突判定」を行なう。出力するモーションは、その仮想球に対応したものとするわけだ。

| 【歩行モーション生成】 | |

|---|---|

|  |

| 「歩行の際の地面との衝突判定」は「事前計算で生成した仮想球の選択」に置き換えられる(左)。そのパフォーマンス(右) | |

| 【スフィアを使った移動】 |

|---|

|

| ランタイムで衝突判定に用いる仮想球は事前に生成 |

|

| 歩行モーション再生中に、試験的に仮想球を可視化させた映像 |

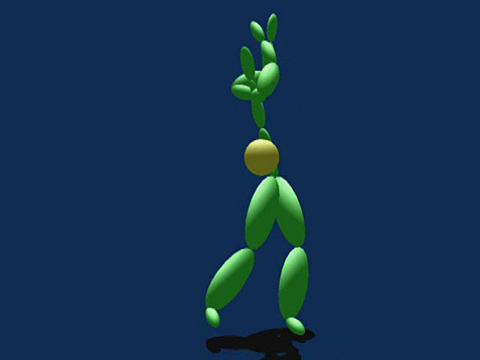

次に紹介されたのは、そうしたデータ駆動型アプローチの歩行モーションに、さらに力学作用を合成させる技術だ。こちらはスクウェア・エニックス・ヨーロッパ(旧EIDOSグループ)が開発した歩行モーション生成エンジン「ANGEL WALKER」を、日本のスクウェア・エニックスのテクノロジー推進部が独自拡張したものになる。

ただ、歩行、走行するだけでなく、力学作用として重心速度も算出するため、走行時にはやや前傾姿勢になったりするモーションがプロシージャル付加される。デモでは急激な姿勢変化で首を動かしたりするモーションが介入することがあったが、これらはあらかじめ設定されたルールに従って実行されたモーションだとのことだ。「生身っぽさを出すための演出」と捉えてもいいかもしれない。

その他、足と地面の作用力も配慮されるという。なので、例えば下り斜面で急に静止したりすれば前のめり気味になって小刻みに踏ん張るようなモーションが追加される。

| 【ANGEL WALKER】 | ||

|---|---|---|

|  |  |

| ANGEL WALKERは歩行モーションと力学との融合事例 | ||

|

| AIとアニメーションシステムとの統合は将来展望の1つ |

最後に、向井氏は今後の展望などについて語った。今回紹介していたような、データ駆動型技術を進化させ、物理・力学との融合をさらに進めていくこと以外に、強調していたのは「AI」との連携・統合だ。

現在のAIでは、その出力が「歩行→攻撃→後退」といった感じの「コマンド羅列」的な離散的な意志決定が主体であり、それらをひとつひとつアニメーション化していくような表現が主流だが、意志自体を複合化・連続化し、それらを連続したアニメーションとして反映させられることを目指したいというのだ。

あるいは、動的に変化する環境下において、「今、こういうアニメーション(アクション)が行えるから、こう動くべき」というような、アニメーション起点のAIの意志決定というのも将来的には必要になってくるだろう、と向井氏は述べていた。

アニメーションとAIの連携・統合が達成されたとき、ゲームは新しい次元に踏み出せるようになるかもしれない。

□スクウェア・エニックスのホームページ

http://www.square-enix.com/jp/

□「スクウェア・エニックス オープンカンファレンス」のホームページ

http://www.square-enix.com/jp/info/open_conference.html

(2011年 10月 12日)

![映画『THE FIRST SLAM DUNK』STANDARD EDITION [Blu-ray] 製品画像:1位](https://m.media-amazon.com/images/I/51-wwO3yn7L._SL160_.jpg)

![【Amazon.co.jp限定】『ウマ箱3』第4コーナー アニメ『ウマ娘 プリティーダービー Season 3』トレーナーズBOX) (全巻購入特典「描き下ろし全巻収納BOX」+「ボイスレコードキーホルダー」+「場面写真ポストカードセット」付) [Blu-ray] 製品画像:2位](https://m.media-amazon.com/images/I/41afWRQQkIL._SL160_.jpg)

![映画『THE FIRST SLAM DUNK』STANDARD EDITION [DVD] 製品画像:3位](https://m.media-amazon.com/images/I/51maeMy2M1L._SL160_.jpg)

![【Amazon.co.jp限定】ちいかわ 豪華版 2(長方形缶バッジ 付) [Blu-ray] 製品画像:4位](https://m.media-amazon.com/images/I/41uo59pqI2L._SL160_.jpg)

![ガールズ&パンツァー 最終章 第4話 (特装限定版) [Blu-ray] 製品画像:5位](https://m.media-amazon.com/images/I/51pKQ3HJg0L._SL160_.jpg)

![わんだふるぷりきゅあ! vol.15 [DVD] 製品画像:7位](https://m.media-amazon.com/images/I/51vJgbj9o3L._SL160_.jpg)

![魔法少女にあこがれて 第2巻 [Blu-ray] 製品画像:8位](https://m.media-amazon.com/images/I/51q+vvcgNfL._SL160_.jpg)

![魔法少女にあこがれて 第1巻《通常版》 [Blu-ray] 製品画像:9位](https://m.media-amazon.com/images/I/919D-QRNWZL._SL160_.jpg)

![【送料無料】[限定盤][早期予約特典付]ライブアルバム「W encore」(初回限定盤)/ワルキューレ[CD+Blu-ray]【返品種別A】 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/joshin-cddvd/cabinet/094/vtzl-241.jpg?_ex=128x128)

![【送料無料】TVアニメ『葬送のフリーレン』Original Soundtrack/Evan Call[CD]【返品種別A】 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/joshin-cddvd/cabinet/804/thca-60290.jpg?_ex=128x128)

![夢幻 [ 水樹奈々 ] 製品画像:4位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7328/4988003377328.jpg?_ex=128x128)

![PHANTOM MINDS [ 水樹奈々 ] 製品画像:6位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0205/4988003380205.jpg?_ex=128x128)

![Get up! Shout! [ 水樹奈々 ] 製品画像:7位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9134/4988003589134.jpg?_ex=128x128)

![TVアニメ「WHITE ALBUM」オープニングテーマ::深愛 [ 水樹奈々 ] 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5196/4988003365196.jpg?_ex=128x128)

![Exterminate [ 水樹奈々 ] 製品画像:9位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0432/4988003470432.jpg?_ex=128x128)

![METANOIA (TVアニメ「戦姫絶唱シンフォギアXV」OPテーマ) [ 水樹奈々 ] 製品画像:10位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6052/4988003546052_2.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典】デート・ア・ライブ5 Blu-ray BOX 上巻《通常版》【Blu-ray】(オリジナルA5キャラファイングラフ) [ 橘公司 ] 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4401/2100013884401.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典】デート・ア・ライブ5 Blu-ray BOX 下巻【Blu-ray】(オリジナルA5キャラファイングラフ) [ 橘公司 ] 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4418/2100013884418.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典+早期予約特典】この素晴らしい世界に祝福を!3 第1巻《オリジナルポケット人生ゲーム付き完全数量限定版》【Blu-ray】(オリジナルA5キャラファイングラフ+原作イラスト・三嶋くろね描き下ろしA3クリアポスター) [ 暁なつめ ] 製品画像:4位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6659/4988111666659.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典】この素晴らしい世界に祝福を!3 第4巻【Blu-ray】(オリジナルA5キャラファイングラフ) [ この素晴らしい世界に祝福を! ] 製品画像:5位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5830/2100013905830_1_2.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典】この素晴らしい世界に祝福を!3 第2巻【Blu-ray】(オリジナルA5キャラファイングラフ) [ この素晴らしい世界に祝福を! ] 製品画像:6位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5816/2100013905816_1_2.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典】この素晴らしい世界に祝福を!3 第3巻【Blu-ray】(オリジナルA5キャラファイングラフ) [ この素晴らしい世界に祝福を! ] 製品画像:7位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5823/2100013905823_1_2.jpg?_ex=128x128)

![【送料無料】[限定版][先着特典付]にじよん あにめーしょん2 Blu-ray BOX(特装限定版)/アニメーション[Blu-ray]【返品種別A】 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/joshin-cddvd/cabinet/246/bcxa-1924.jpg?_ex=128x128)

![にじよん あにめーしょん2 Blu-ray BOX(特装限定版)【Blu-ray】 [ 矢立肇 ] 製品画像:9位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9246/4934569369246.jpg?_ex=128x128)

![【楽天ブックス限定全巻購入特典+全巻購入特典】ガールズバンドクライ第4巻(豪華限定版)【Blu-ray】(アクリルスタンド(全員絵柄)1種+描きおろし全巻収納BOX) [ ガールズバンドクライ ] 製品画像:10位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/noimage_01.gif?_ex=128x128)

![葬送のフリーレン(13)【電子書籍】[ 山田鐘人 ] 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4312/2000014924312.jpg?_ex=128x128)

![【推しの子】 14【電子書籍】[ 赤坂アカ×横槍メンゴ ] 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1581/2000014681581.jpg?_ex=128x128)

![シャングリラ・フロンティア(17) ~クソゲーハンター、神ゲーに挑まんとす~【電子書籍】[ 硬梨菜 ] 製品画像:3位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9535/2000014959535.jpg?_ex=128x128)

![キングダム 72 (ヤングジャンプコミックス) [ 原 泰久 ] 製品画像:6位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2378/9784088932378.gif?_ex=128x128)

![辺境の老騎士 バルド・ローエン(11)【電子書籍】[ 菊石森生 ] 製品画像:7位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/3900/2000014963900.jpg?_ex=128x128)

![葬送のフリーレン(13) (少年サンデーコミックス) [ 山田 鐘人 ] 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2339/9784098532339_1_5.jpg?_ex=128x128)

![葬送のフリーレン 13 ステッカーセット付き特装版 (少年サンデーコミックス) [ 山田 鐘人 ] 製品画像:9位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1587/9784099431587_1_5.jpg?_ex=128x128)

![[新品]リ・モンスター Re:monster (1-11巻 最新刊) 全巻セット 製品画像:10位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0013/m2434428810_01.jpg?_ex=128x128)